Sommaire

Dès qu'un site Web est en ligne, tous les accès au serveur sont automatiquement enregistrés dans des fichiers journaux. Plus vous appelez de visiteurs sur vos sites Web, plus vous pouvez évaluer les données à l'aide d'une analyse de fichier journal. Comment cela fonctionne-t-il, quels sont les avantages de l'analyse et auxquels vous devriez prêter attention, vous apprendrez dans cette introduction facile à comprendre.

Que sont les fichiers de log?

Chaque fois que vous accédez à votre serveur Web, une entrée de données est automatiquement créée. Cette collection de données s'appelle "logfile" et est généralement stockée dans le répertoire racine de votre site Web.

Le serveur peut stocker les données suivantes dans un fichier journal:

- le système d'exploitation que l'utilisateur ou le client utilise

- le navigateur utilisé pour l'accès

- l'heure et la date d'accès

- Commandes demandées par le serveur

- la nature du protocole, par exemple https

- le nombre d'octets transférés

- l'URL précédemment appelée par l'utilisateur

- la réponse du serveur

- le nom du fichier et le chemin du fichier

- l'adresse IP ou l'adresse DNS

Comme vous pouvez le constater, jusqu'à dix points de données différents peuvent être enregistrés via un seul accès.

Vous pouvez télécharger les fichiers journaux directement à partir du serveur et les afficher et les traiter avec un outil tel que des feuilles de calcul Excel ou Google.

Quelles données sont pertinentes pour l'analyse du fichier journal?

Fondamentalement, vous pouvez tirer des conclusions importantes de toutes les données existantes sur les performances du site Web et le fonctionnement des Googlebots.

Étant donné que les fichiers journaux peuvent devenir très volumineux, il est important de limiter la quantité de données. Le moyen le plus simple consiste à limiter la période de visionnage. Souvent, si vous regardez une fenêtre d'une semaine ou consultez les fichiers journaux après avoir modifié la page ou déplacé une mise à jour Google importante.

Théoriquement, vous pouvez toujours analyser toutes les données en même temps, peu importe la période. Rappelez-vous toutefois que vous avez besoin des ressources nécessaires pour cela.

Que devrais-je évaluer les fichiers journaux?

Il existe différentes utilisations pour vos fichiers journaux. Bien sûr, vous pouvez analyser le comportement de l'utilisateur. Mais pour cela, vous avez généralement des outils beaucoup plus utiles avec des outils d'analyse Web tels que Google Analytics ou la console de recherche Google.

La vue dans l'analyse du fichier journal concerne donc davantage les robots qui visitent votre site, en particulier Googlebot.

Les aspects suivants sont importants ici:

Comment votre site Web a-t-il été exploré?

Si vous identifiez Googlebot en tant que client, vous pouvez utiliser l'analyse du fichier journal pour déterminer comment le bot gère vos URL. Par exemple, vous pouvez voir à quelle fréquence Googlebot explore quelles pages. De plus, vous pouvez déterminer comment le bot traite les paramètres.

Quelle est la vitesse de mon site web?

Bien entendu, Google Analytics vous indiquera également à quelle vitesse votre serveur répond. L'analyse du fichier journal vous donne un aperçu plus détaillé et vous indique combien de temps un bot doit télécharger une ressource de votre serveur.

Y a-t-il des problèmes d'indexation?

L'analyse du fichier journal peut vous montrer exactement si les robots téléchargent vos pages complètement ou seulement partiellement. De même, les journaux d'accès vous aident à identifier les pages peu performantes. Par exemple, si Googlebot ne peut pas charger complètement vos URL, des problèmes techniques pourraient l’empêcher de s’explorer. En outre, le fichier robots.txt peut être bogué, l'empêchant ainsi d'être exploré sur tout le site.

Quels sont les Googlebots qui explorent votre page?

Google utilise différents robots d'exploration pour les images ou l'index mobile. L'activité de ces robots peut vous indiquer si votre site Web est de préférence analysé pour le contenu mobile. Ici, vous regardez mieux la relation avec le Googlebot standard.

À quelle fréquence une URL est-elle explorée?

La fréquence d'analyse vous permet de voir si vos URL sont pertinentes pour Googlebot. Les URL moins importantes pour Google seront explorées moins souvent. Vous pouvez ensuite en déduire des mesures d'optimisation. Pour que Googlebot tire le meilleur parti de son budget d'analyse, l'actualité d'une URL joue également un rôle important. Ainsi, par exemple, vous devez régulièrement mettre à jour ou actualiser le contenu pour augmenter la fréquence d'analyse de Googlebot.

Y a-t-il des problèmes d'exploration?

En fonction de la réponse du serveur, qui est également stockée dans les fichiers journaux, vous pouvez voir si Googlebot a des problèmes d'analyse avec vos URL. De même, vous obtenez des indications sur les chaînes de transfert possibles ou les URL incorrectes. Les chaînes de redirection empêchent Googlebot d’analyser votre page de manière optimale. L’analyse est donc interrompue en cas de doute.

Sur la base de ces questions, vous effectuez l'analyse du fichier journal. Vous devez traiter une quantité énorme de données et interpréter ce cours significatif. Dans l'étape suivante, il est important de tirer des données également des mesures pour améliorer les performances de votre site web.

Analyse du fichier journal et protection des données: vous devez faire attention!

Les fichiers journaux contenant les adresses IP, le navigateur utilisé et le système d'exploitation utilisé par les utilisateurs, vous devez prendre en compte la protection des données lors du traitement de ces données.

Vous devriez faire ça:

- Ajuster la politique de confidentialité: Informez vos utilisateurs dans la politique de confidentialité que vous évaluez ces données. Assurez-vous également dans la déclaration que les enregistrements sont utilisés uniquement à des fins statistiques et ne seront pas partagés avec des tiers. Si vous utilisez un outil à cette fin, un contrat de traitement de données correspondant doit être disponible conformément à DSGVO.

- Aucun lien vers d'autres données: Pour des raisons de protection des données, vous ne devez pas fusionner ou lier les données de l'analyse du fichier journal avec d'autres données, par exemple. avec les données personnelles du client.

- Anonymiser les adresses IP: Afin de respecter les normes strictes de protection des données, vous devez anonymiser les adresses IP ou les enregistrer de manière anonyme sur votre serveur.

Limites de l'analyse du fichier journal

Bien que vous puissiez analyser beaucoup de données avec les fichiers journaux. Néanmoins, il peut y avoir des problèmes avec l'analyse des données. Nous vous montrons les sources d'erreur possibles et comment vous pouvez les résoudre:

Les robots des outils de référencement prétendent être Googlebot

Dans ce cas, une analyse de vos fichiers journaux peut générer des données incorrectes. Vous pouvez corriger cette erreur en effectuant une recherche DNS. Cela vous dira s'il s'agit vraiment d'un Googlebot ou d'un autre robot.

La quantité de données est énorme et ne peut plus être modifiée pour vous

Un petit exemple à l’avance: si vous exploitez un site Web plus grand et que 1 000 visiteurs par jour environ accèdent à votre serveur, y compris le trafic généré par les bots, plus de 1 000 entrées sont créées dans le fichier journal. En un mois à peine, plus de 30 000 lignes sont réunies dans un fichier Excel. Mais que se passe-t-il si vous obtenez dix fois plus de trafic? Au plus un million de lignes au plus tard, des outils tels que Excel ou même des tableurs Google atteindront leurs limites. Des processus simples, tels que les fonctions de tri ou de comptage, nécessitent alors une puissance de calcul si importante qu'ils ne peuvent plus être gérés avec des mémoires à accès aléatoire classiques. Les remèdes possibles ne peuvent alors fournir des services cloud que pour des opérations arithmétiques plus importantes.

Toutes les données pertinentes ne sont pas enregistrées

Vous avez la possibilité de personnaliser le type de données stockées. Mais il peut arriver rapidement que le stockage du fichier journal n’ait pas été configuré correctement et que trop peu de données soient enregistrées ou que vos listes soient incomplètes. Par conséquent, vous devez toujours évaluer les fichiers journaux régulièrement et en vérifier l'exhaustivité.

Les fichiers journaux sont insuffisants pour analyser le comportement de l'utilisateur

L'analyse du fichier journal est principalement une analyse des accès de bot. Parce que les ensembles de données ne sont pas suffisants pour une analyse détaillée de l'utilisateur. Pour cette raison, les fichiers journaux peuvent uniquement constituer un complément aux outils d'analyse Web existants, sans toutefois les remplacer dans l'analyse utilisateur.

conclusion

Avec les fichiers de log, vous avez automatiquement stocké sur le serveur une énorme base de données pour l’analyse des robots. Ce n'est pas si facile d'obtenir ces données précieuses.

Les données collectées peuvent ensuite être traitées et analysées sur de petits sites Web à l'aide de feuilles de calcul standard telles que des feuilles de calcul Excel ou Google. Mais dès que vous avez plusieurs milliers de visites par jour, vous avez besoin de ressources très importantes pour analyser efficacement les fichiers journaux. Sans outils appropriés ni puissance informatique, vous atteindrez vos limites. En outre, il est important de prendre en compte le GDPR afin que les sessions utilisateur ne tombent pas entre de mauvaises mains. Tout cela implique une utilisation importante des ressources (personnel, technologie, temps), ce qui entraîne des coûts correspondants et, du fait des efforts fournis, des analyses irrégulières.

Pour remédier à cela, SEO Expertise vous propose une alternative simple et rapide à l’analyse classique des fichiers journaux.

BotLogs – l'alternative intelligente à l'analyse de fichier journal

Les journaux des robots de SEO Expertise reposent sur deux principes clés: la sélection intelligente des données et la technologie intelligente.

La sélection des données garantit que seul le trafic bot est traité, les sessions utilisateur entrantes sont ignorées. Cela réduit considérablement la quantité de données à analyser et vous aide à vous concentrer sur les robots.

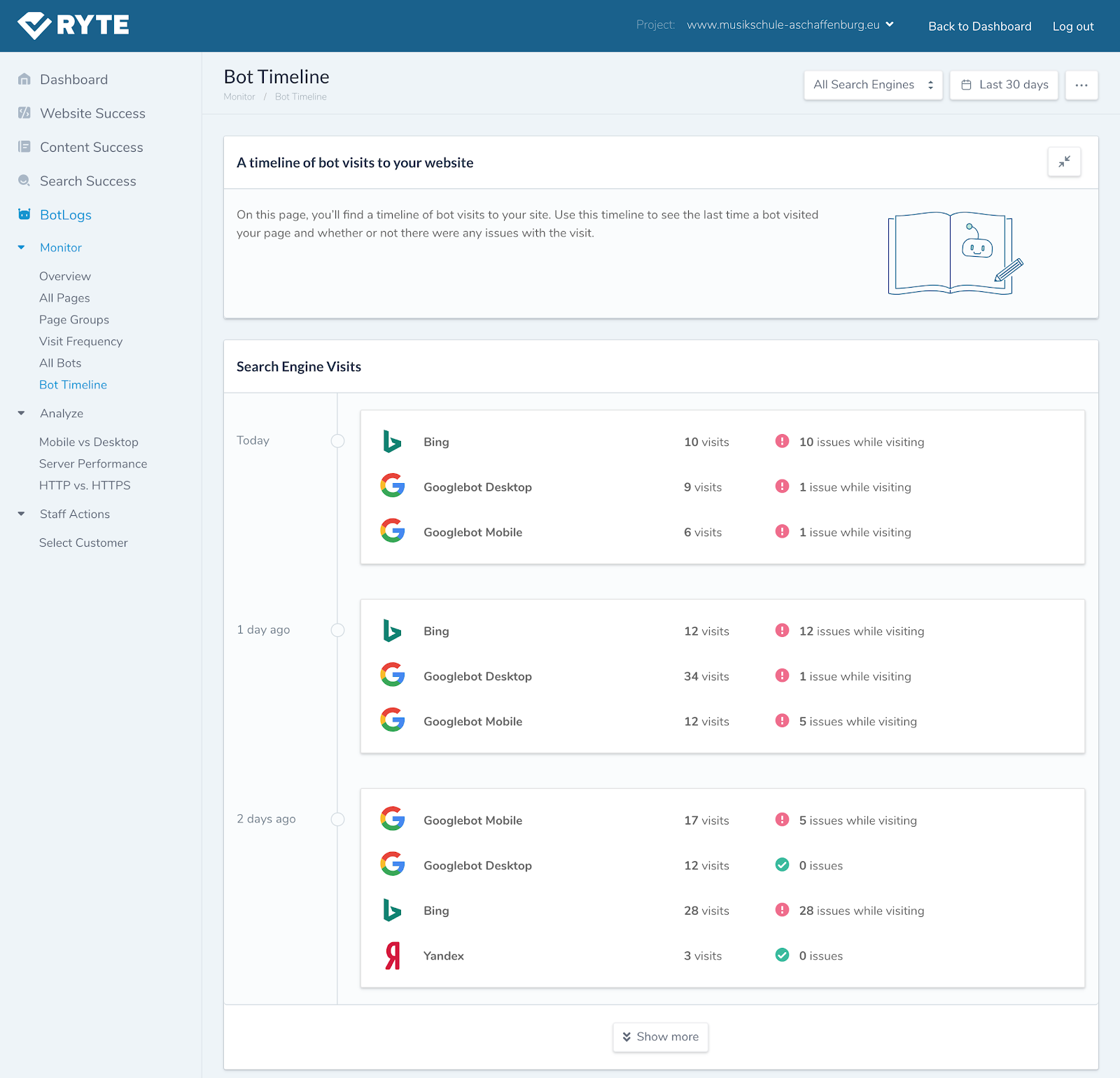

Figure 1: Liste des robots qui ont visité votre page.

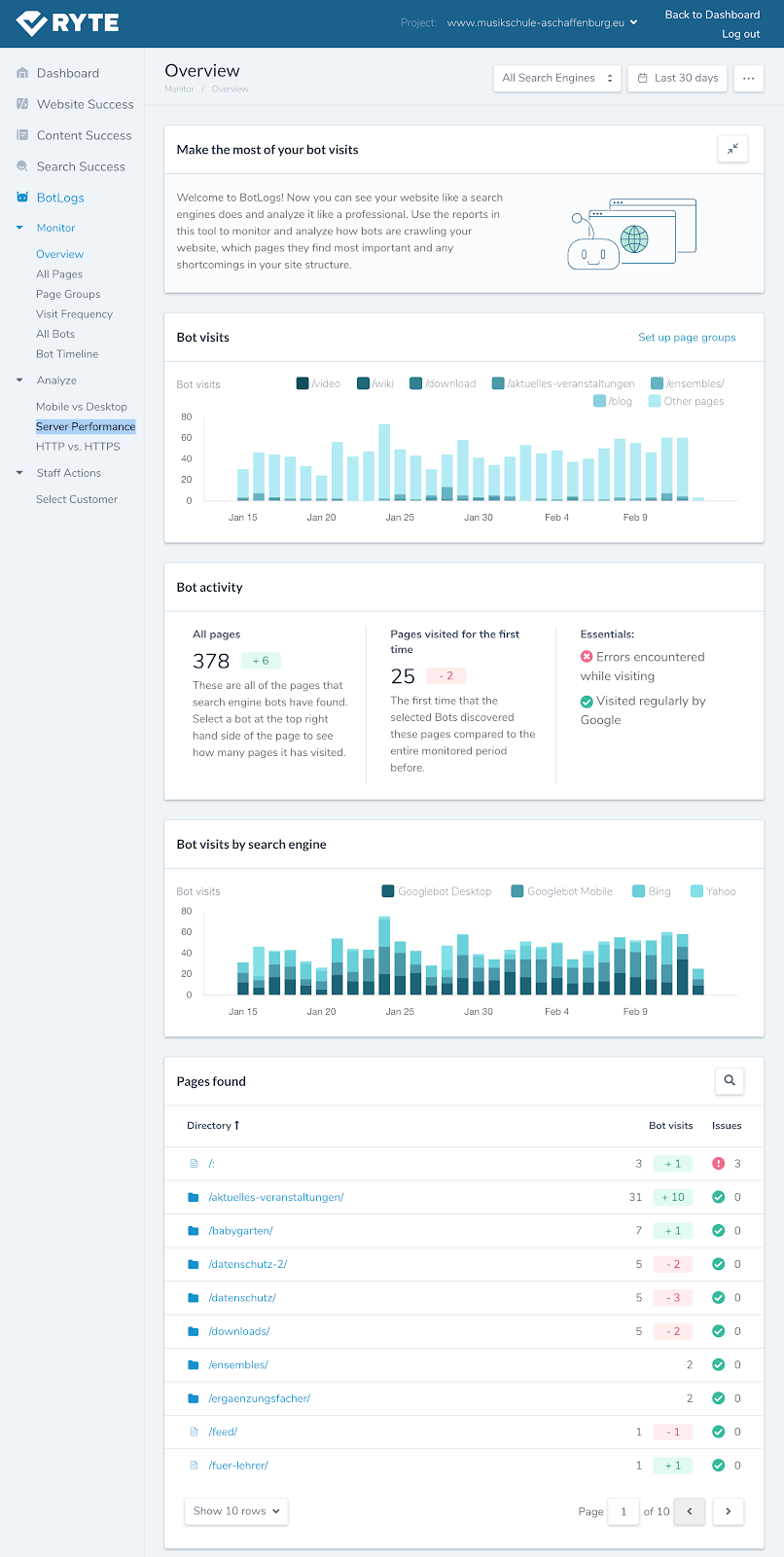

En outre, BotLogs offre un accès facile aux données extraites via un tableau de bord clair avec des visualisations des données clés.

Figure 2: Tableau de bord des journaux de bots.

Vous pouvez ainsi afficher vos URL du point de vue d'un moteur de recherche, les analyser de manière professionnelle et optimiser votre budget d'analyse. De plus, vous travaillez selon DSGVO et avez un accès illimité aux données historiques.

Bien entendu, vous recevrez également les informations correspondantes sur les aspects importants d’une analyse de fichier journal déjà mentionnée ci-dessus:

- Identification des URL analysées

- Observer la fréquence d'analyse des différents robots

- Révéler des liens brisés et des défauts de page ou des redirections inutiles

- Détails de performance du serveur

Et le meilleur: La mise en œuvre prend 1 minute. Vous pouvez ainsi obtenir les premières données en temps réel après 2 minutes.