Sommaire

Googlebot ne dispose pas d'une grande capacité d'analyse d'une page Web. Pour cette raison, il ne dispose que d'un budget d'analyse limité.

Cependant, il n’ya pas eu depuis longtemps de définition officielle de ce qu'est le budget d'analyse. Cela a maintenant changé Google et le terme dans un message séparé dans le Webmaster Central le 16.1.2017 expliqué plus en détail.

Pour que les moteurs de recherche tels que les utilisateurs de Google puissent fournir des résultats actuels et pertinents à leurs requêtes, le Web doit être analysé en permanence par des robots. Cette analyse constitue la base de l'indexation de votre page Web dans les listes de résultats de recherche.

Cependant, Googlebot ne peut pas explorer en permanence tous les sites Web, son activité est limitée (le soi-disant budget d'analyse). Dans l'article de Gary Illyes du 16 janvier 2017, le budget d'analyse de Googlebot est défini comme suit:

Cette définition est complétée par d'autres explications dans l'article.

Il faut en tirer les enseignements suivants:

1. Le budget d'analyse est important pour l'indexation de votre site Web.

Plus le budget de Googlebot est élevé, plus votre domaine peut explorer de pages. Par conséquent, davantage de contenu peut être indexé et affiché dans les SERP.

2. Les domaines avec moins de 1 000 URL ont plus facile

Selon la déclaration de Gary Illyes En règle générale, le budget d'analyse n'a aucun impact sur les pages Web nouvellement publiées, car elles sont néanmoins analysées par Googlebot. En outre, le budget d'analyse ne joue pas un rôle important pour les domaines comportant moins de 1 000 URL, car Googlebot peut analyser efficacement ce nombre. En outre, d'autres facteurs, tels que la capacité du serveur du site Web, ainsi que la hiérarchisation des URL à analyser jouent un rôle.

3. Plus la page est rapide, meilleur est le taux d'analyse.

Tout webmaster impliqué dans le référencement sait que les sites Web rapides ont un impact positif sur la convivialité. Cependant, les réponses rapides du serveur présentent également des avantages pour l'analyse. Plus une page Web répond rapidement, plus le taux d'analyse de Googlebot est élevé et plus le nombre de connexions simultanées utilisables pour l'analyse étant élevé. Si vous souhaitez tirer le meilleur parti du budget d’exploration de Googlebot, vous devez faire attention aux serveurs rapides et aux sites Web à chargement rapide.

Le taux d'analyse peut également être contrôlé à partir de la console de recherche Google. Cela permet aux webmasters de réduire la fréquence pour économiser la capacité du serveur. Cependant, une augmentation n'entraîne pas automatiquement une fréquence d'analyse plus élevée.

4. Ramper n'est pas un facteur de classement

Un taux d'analyse plus élevé ne conduit pas nécessairement à de meilleures positions dans les résultats de recherche. (Gary Illyes, Google)

Fondamentalement, l’exploration d’un site Web n’est pas pertinente pour le classement. Cependant, il semble évident que la probabilité d'obtenir un bon classement augmente au fur et à mesure que votre site Web est analysé.

Ainsi, les algorithmes peuvent toujours correspondre au moteur de recherche et déterminer dans quelle mesure votre page est adaptée à une requête de recherche.

5. La demande rampante dépend de plusieurs facteurs

Googlebot fait en sorte que le budget de l'analyse dépende du temps nécessaire à l'analyse de votre page. Il n'a même pas à épuiser tout son budget.

Le bot explore plus souvent les pages Web, qui, selon Illyes, sont "plus populaires". La popularité sur le Web est généralement exprimée par le nombre de backlinks entrants. Ainsi, un site Web plus fortement lié est également exploré plus fréquemment. Une page contenant un contenu très à jour et constamment mis à jour, telle qu'une page d'actualités, pourrait également être populaire. Malheureusement, Illyes ne s'attarde pas sur la "popularité".

D'autre part, il est clair que Googlebot considère qu'il est nécessaire d'analyser les pages indexées obsolètes. Mais même ici, la déclaration reste non spécifique. Toutefois, un transfert de domaine est un signal clair à Googlebot pour l'exploration de la page.

6. Toutes les URL d'une page sont prises en compte pour le budget d'analyse

Googlebot suit toutes les URL de votre page. Par conséquent, toutes les URL du budget d'analyse sont incluses. Peu importe qu'il s'agisse d'URL incorporées, d'URL alternatives pour hreflang ou d'AMP. Si vous souhaitez enregistrer le budget d'analyse, supprimez les URL inutiles sur votre page.

7. Certains facteurs ont un impact négatif sur le budget d'analyse

Google doit penser économiquement, après tout, il y a beaucoup d'URL qui doivent être explorées quotidiennement. Et même une entreprise telle que Google ne souhaite pas dépenser des ressources financières inutiles pour l'exploration de sites Web.

Dans son article, Gary Illyes définit exactement les facteurs qui réduisent le budget d'analyse:

- Navigation à facettes: Il peut s’agir, par exemple, de filtres générant une nouvelle URL pour chaque extension.

- Dupliquer le contenu

- Soft 404 pages d'erreur

- Pages qui ont été piratés

- Pages qualitativement inférieures

- pages de spam

- Pages infiniment extensibles: il peut s'agir, par exemple, de calendriers générant une nouvelle URL par jour.

Donc, vous pouvez économiser le budget d'analyse des Googlebots

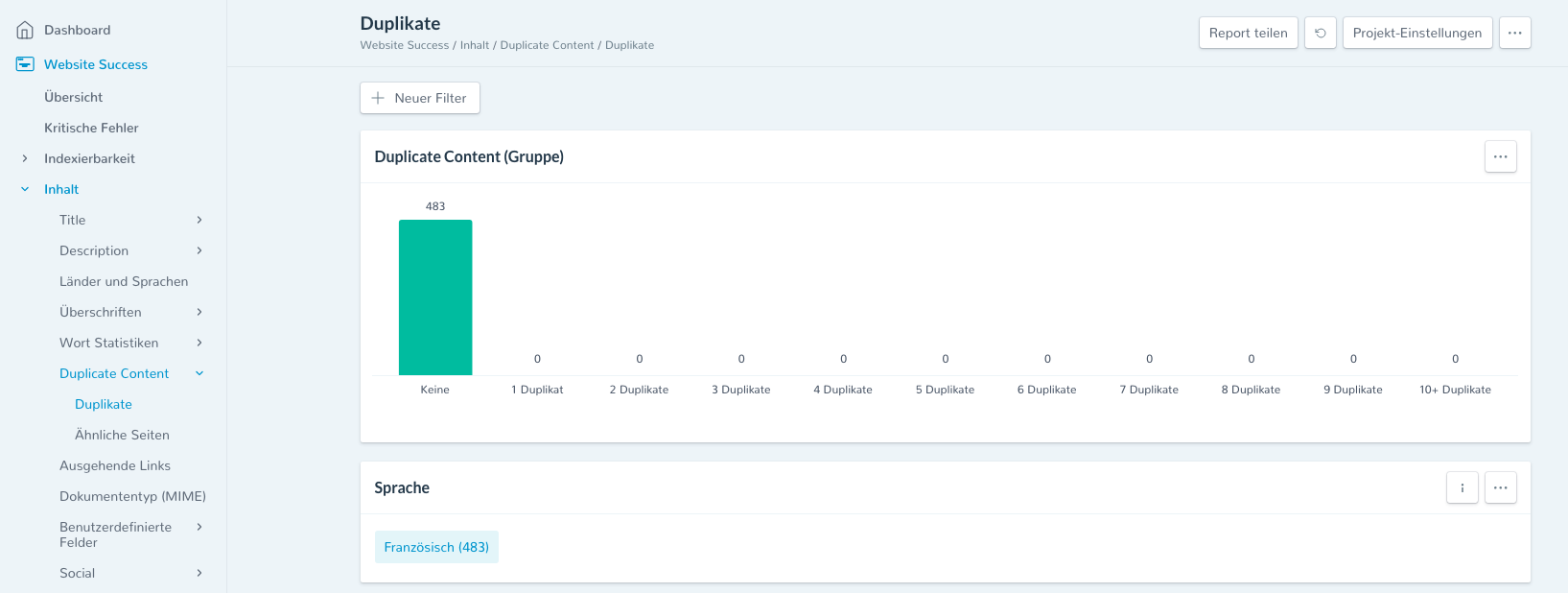

Le moyen le plus simple de tirer le meilleur parti de votre budget d'analyse est de réduire le contenu en double. Ici, SEO Expertise peut vous aider: Identifiez les pages pertinentes et supprimez-les si possible.

Figure 1: Identifiez le contenu en double avec SEO Expertise.

Figure 1: Identifiez le contenu en double avec SEO Expertise.

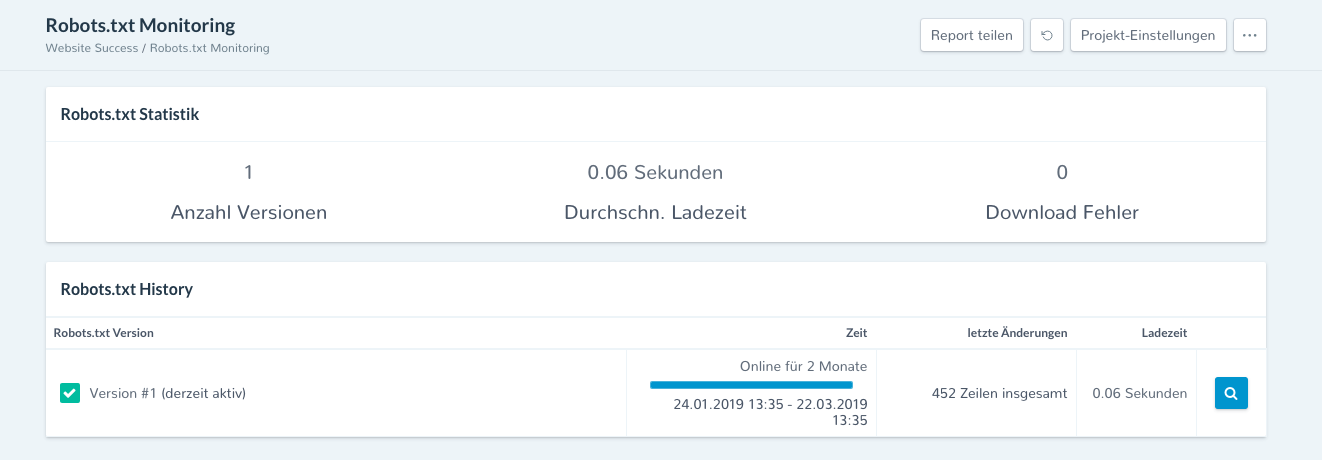

En outre, vérifiez votre fichier robots.txt et assurez-vous que Googlebot peut analyser toutes les zones pertinentes.

Figure 2: La surveillance robots.txt de SEO Expertise

Mettez également à jour votre plan Sitemap régulièrement. Ainsi, vous montrez à Googlebot toutes les URL importantes de votre site Web, qu’il peut suivre.

conclusion

✓ permettre à Googlebot d'analyser et d'augmenter la demande d'analyse avec du contenu récent.

✓ Recherchez régulièrement des erreurs de serveur sur votre site à l'aide de la console de recherche ou Search Success par SEO Expertise,

✓ Évitez également les sites à faible valeur ajoutée, les doublons de contenu ou les spams.

Vous avez déjà enregistré votre budget d’exploration en quelques étapes et optimisé votre site Web. Le Googlebot vient quand même sur votre site, mais vous l'avez en main, s'il épuisait vraiment son contingent!