Sommaire

Définition du scraping : qu’est-ce que le scrape web ?

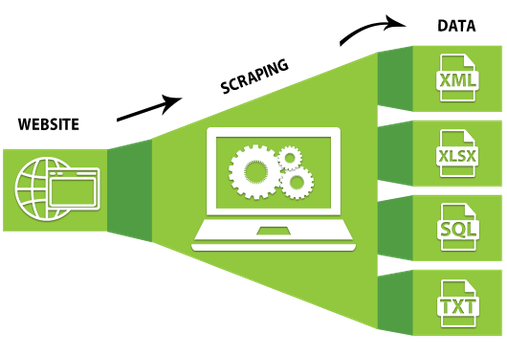

Définition du scraping : historiquement, lorsque les référenceurs SEO et les webmasters parlent de scraping, ils parlent de scraping d’écran ou de web scraping.

Le scraping est le processus d’extraction du contenu d’un site Web et de son incorporation dans un autre site Web, souvent avec une conception ou un objectif différent.

Il existe des utilisations positives du scrape, ainsi que des utilisations négatives, qui sont expliquées plus en détail ci-dessous.

Le scraping Web est connu sous de nombreux autres noms selon ce qu’une entreprise veut l’appeler, le scraping d’écran, l’extraction de données Web, le Web Harvesting et plus encore. Peu importe comment vous l’appelez, il s’agit d’une technique utilisée pour extraire de grandes quantités de données à partir de sites Web.

Les données sont extraites de divers sites Web et supports de stockage et stockées localement pour une utilisation ou une analyse immédiate, généralement effectuée ultérieurement.

Les données sont stockées le plus souvent dans un système de fichiers local ou dans des tables de base de données en fonction de la structure des données extraites.

La plupart des sites Web que nous visitons régulièrement nous permettent de visualiser uniquement le contenu et n’autorisent généralement pas la copie ou le téléchargement. Copier manuellement les données est aussi efficace que de couper des articles de journaux et peut prendre des jours ou des semaines.

Les techniques d’automatisation de ce processus afin qu’un script intelligent puisse vous aider à extraire les données des pages Web de votre choix et à les stocker dans un format structuré.

Qu’est-ce que le scraping ?

Il existe un certain nombre d’options techniques différentes disponibles pour scraper. Le scrape se fait automatiquement ou manuellement à l’aide d’outils dédiés. De plus, le scrape via la manipulation http et l’exploration de données est possible. La copie manuelle du contenu est également appelée scrape ou scraping.

Découvre un logiciel de scraping 100% français

Pourquoi faire du scraping ?

Il existe diverses raisons de scraper. Par exemple, il existe une variété d’outils d’analyse qui extraient des données d’un site Web et les traitent ensuite à des fins spécifiques. Par exemple, un outil vérifie le placement d’un site Web pour un mot-clé spécifique sur Google et accède ainsi aux SERP.

Les flux RSS peuvent également être intégrés à d’autres sites Web et outils et représenter une forme de scrape. Par exemple, les informations sur les conditions météorologiques ou les horaires des transports en commun utilisent le scraping.

En général, l’extraction de données Web est utilisée par les personnes et les entreprises qui souhaitent utiliser la grande quantité de données Web accessibles au public pour prendre des décisions plus intelligentes.

Dans le monde du e-commerce, le web data scraping est largement utilisé pour la surveillance des prix des concurrents. C’est le seul moyen pratique pour les marques de vérifier les prix des produits et services de leurs concurrents, leur permettant d’affiner leurs propres stratégies de prix et de garder une longueur d’avance. Il est également utilisé comme outil par les fabricants pour s’assurer que les détaillants respectent les directives de prix pour leurs produits. Les organismes d’études de marché et les analystes dépendent de l’extraction de données Web pour évaluer le sentiment des consommateurs en suivant les critiques de produits en ligne, les articles de presse et les commentaires.

Il existe une vaste gamme d’applications d’extraction de données dans le monde financier. Les outils de scrapage 😊 de données sont utilisés pour extraire des informations des reportages, en utilisant ces informations pour guider les stratégies d’investissement. De même, les chercheurs et les analystes dépendent de l’extraction de données pour évaluer la santé financière des entreprises. Les compagnies d’assurance et de services financiers peuvent exploiter un riche gisement de données alternatives extraites du Web pour concevoir de nouveaux produits et polices pour leurs clients.

Les applications d’extraction de données Web ne s’arrêtent pas là. Les outils de récupération de données sont largement utilisés dans la surveillance des actualités et de la réputation, le journalisme, la surveillance SEO, l’analyse des concurrents, le marketing basé sur les données et la génération de leads, la gestion des risques, l’immobilier, la recherche universitaire, et bien plus encore.

Comment les données de tarification Web et l’intelligence des prix peuvent être utiles :

- Tarification dynamique

- Optimisation des revenus

- Veille concurrentielle

- Suivi des tendances produits

- Conformité de la marque et du MAP

Les études de marché sont essentielles et doivent être guidées par les informations les plus précises disponibles. Des données Web de haute qualité, à volume élevé et très pertinentes, de toutes formes et tailles, alimentent l’analyse de marché et l’intelligence économique dans le monde entier.

- Analyse des tendances du marché

- Tarification du marché

- Optimisation du point d’entrée

- Recherche & Développement

- Veille concurrentielle

Visite guidée de Scrap.io : comment scraper Google ?

Scrap.io est un outil pour capturer des leads B2B en masse en utilisant la data de Goole Maps de manière 100% légale.

Leads en illimité depuis Google Maps

Recherchez et téléchargez autant de leads que vous le souhaitez.

Essayez gratuitement pendant 7 jours sans engagement.

Génération de leads

La génération de leads est une activité marketing/vente cruciale pour toutes les entreprises. Dans le rapport Hubspot 2020 , 61 % des spécialistes du marketing entrant ont déclaré que générer du trafic et des prospects était leur défi numéro 1. Heureusement, l’extraction de données Web peut être utilisée pour accéder à des listes de prospects structurées à partir du Web.

Obtiens des leads grâce à Scrap.io

Grattage web – Comment fonctionne un logiciel de scraping Web ?

Le logiciel de scraping Web charge automatiquement plusieurs pages Web les unes après les autres et extrait les données selon les besoins. Il est soit conçu spécifiquement pour un site Web spécifique, soit configuré en fonction d’un ensemble de paramètres pour fonctionner avec n’importe quel site Web. D’un simple clic sur un bouton, vous pouvez facilement enregistrer les données disponibles sur un site Web dans un fichier sur votre ordinateur.

Dans le monde d’aujourd’hui, des bots intelligents font du web scraping. Contrairement au screen scraping, qui ne fait que copier les pixels affichés à l’écran, ces bots extraient le code HTML sous-jacent ainsi que les données stockées dans une base de données en arrière-plan.

Un outil de scrap envoie généralement des requêtes HTTP à un site Web cible et extrait les données d’une page. Habituellement, il analyse le contenu accessible publiquement et visible par les utilisateurs et rendu par le serveur au format HTML. Parfois, il envoie également des demandes aux interfaces de programmation d’applications (API) internes pour certaines données associées, telles que les prix des produits ou les coordonnées, qui sont stockées dans une base de données et transmises à un navigateur via des requêtes HTTP.

Il existe différents types d’outils de grattage Web, avec des fonctionnalités qui peuvent être personnalisées pour s’adapter à différents projets d’extraction. Par exemple, vous pourriez avoir besoin d’un outil de grattage capable de reconnaître des structures de site HTML uniques, ou d’extraire, de reformater et de stocker des données à partir d’API.

Les outils de scraping peuvent être de grands frameworks conçus pour toutes sortes de tâches de scraping typiques, mais vous pouvez également utiliser des bibliothèques de programmation à usage général et les combiner pour créer un scraper.

Par exemple, vous pouvez utiliser une bibliothèque de requêtes HTTP – telle que la bibliothèque Python-Requests – et la combiner avec la bibliothèque Python BeautifulSoup pour récupérer les données de votre page. Ou vous pouvez utiliser un framework dédié qui combine un client HTTP avec une bibliothèque d’analyse HTML. Un exemple populaire est Scrapy, une bibliothèque open-source créée pour les besoins de scraping avancés.

Le scraping Web est populaire

Et cela ne devrait pas être surprenant, car le web scraping fournit quelque chose de vraiment précieux que rien d’autre ne peut : il vous donne des données Web structurées à partir de n’importe quel site Web public.

Plus qu’une commodité moderne, la véritable puissance du web scraping de données réside dans sa capacité à créer et à alimenter certaines des applications professionnelles les plus révolutionnaires au monde. « Transformatif » ne commence même pas à décrire la manière dont certaines entreprises utilisent les données récupérées sur le Web pour améliorer leurs opérations, en éclairant les décisions de la direction jusqu’aux expériences de service client individuelles.

Apprends à scraper avec cet outil

Le processus de scraping de données Web

Si vous le faites vous-même à l’aide d’outils de grattage de sites Web

Voici à quoi ressemble un processus général de grattage Web DIY :

Identifier le site Web cible

- Collectez les URL des pages dont vous souhaitez extraire les données

- Faire une requête à ces URLs pour obtenir le HTML de la page

- Utilisez des localisateurs pour trouver les données dans le HTML

- Enregistrez les données dans un fichier JSON ou CSV ou dans un autre format structuré

Assez simple, non? Si vous avez juste un petit projet. Mais malheureusement, vous devez relever de nombreux défis si vous avez besoin de données à grande échelle. Par exemple, maintenir le scraper si la mise en page du site Web change, gérer les proxies, exécuter du javascript ou contourner les antibots. Ce sont tous des problèmes profondément techniques qui peuvent consommer beaucoup de ressources. Il existe plusieurs outils de grattage de données Web open source que vous pouvez utiliser, mais ils ont tous leurs limites. C’est en partie la raison pour laquelle de nombreuses entreprises choisissent d’externaliser leurs projets de données Web.

Si vous l’externalisez :

- Notre équipe recueille vos exigences concernant votre projet.

- Notre équipe chevronnée d’experts en web scraping écrit le(s) scraper(s) et met en place l’infrastructure pour collecter vos données et les structurer en fonction de vos besoins.

- Enfin, nous livrons les données dans le format et la fréquence souhaités.

En fin de compte, la flexibilité et l’évolutivité du web scraping garantissent que les paramètres de votre projet, aussi spécifiques soient-ils, peuvent être facilement satisfaits. Les détaillants de mode informent leurs créateurs des tendances à venir sur la base d’informations recueillies sur le Web, les investisseurs chronomètrent leurs positions boursières et les équipes marketing submergent la concurrence avec des informations approfondies, tout cela grâce à l’adoption croissante du Web Scraping en tant que partie intégrante des activités quotidiennes.

Que puis-je utiliser à la place d’un outil de grattage ?

Pour tous les projets, sauf les plus petits, vous aurez besoin d’une sorte d’outil de grattage Web automatisé ou d’un logiciel d’extraction de données pour obtenir des informations à partir de sites Web.

En théorie, vous pouvez couper et coller manuellement des informations de pages Web individuelles dans une feuille de calcul ou un autre document. Mais vous constaterez que cela est laborieux, long et sujet aux erreurs si vous essayez d’extraire des informations de centaines ou de milliers de pages.

Un outil de grattage Web automatise le processus, en extrayant efficacement les données Web dont vous avez besoin et en les formatant dans une sorte de structure bien organisée pour le stockage et le traitement ultérieur.

Une autre voie pourrait être d’acheter les données dont vous avez besoin auprès d’un fournisseur de services de données qui les extraira en votre nom. Cela serait utile pour les grands projets impliquant des dizaines de milliers de pages Web.

Gagne un temps précieux avec Scrap.io

Scrape et spam

Dans les applications possibles décrites ci-dessus, le scraping doit être appréhendé positivement. Cependant, il existe également des exemples où le scraping est assimilé à du spam car il implique des méthodes de référencement illégales.

Par exemple, si une boutique en ligne présente un nouveau produit et copie le texte de description d’une autre boutique en ligne, il s’agit d’un scraping illégal. De plus, dans un tel cas, il y a du contenu en double, ce qui fait plus de mal que de bien au placement des SERP.

Étant donné que le contenu dupliqué peut également conduire à la dévaluation de la page avec le contenu original, les webmasters doivent veiller si le scraping a lieu par rapport à leur propre page.

Les SEO ont plusieurs options pour rendre le scrape plus difficile. Vous pouvez bloquer les robots correspondants via le fichier robot.txt, installer des requêtes de sécurité et optimiser le pare-feu du serveur.

4 conseils pour bien scraper

Bien qu’il s’agisse d’un excellent outil pour obtenir toutes sortes d’informations, vous devez vous occuper de certains problèmes juridiques afin de ne pas avoir d’ennuis.

- Respectez le fichier robots.txt

Vérifiez toujours le fichier Robots.txt , quel que soit le site Web que vous souhaitez récupérer. Le document contient un ensemble de règles qui définissent la manière dont les bots doivent interagir avec le site Web. Cependant, si vous grattez d’une manière qui enfreint ces règles, vous pouvez vous trouver dans une zone grise légale.

- Attention à ne pas stresser trop souvent les serveurs.

Ne devenez pas un scraper permanent. Certains serveurs Web sont victimes de temps d’arrêt lorsque la charge est très élevée. Les bots ajoutent plus de charge d’interaction au serveur d’un site Web, et lorsque la charge dépasse un certain point, le serveur peut devenir lent ou planter, détruisant l’expérience utilisateur d’un site Web.

- Il est préférable de gratter les données pendant les périodes d’inactivité.

Pour éviter de vous enliser dans le trafic Web et les temps d’arrêt du serveur, vous pouvez scraper la nuit ou lorsque vous constatez que le trafic vers un site Web est plus faible.

- Traitement responsable des données

Les directives doivent être suivies et la publication de données protégées par le droit d’auteur peut avoir de graves conséquences. Il est donc préférable que vous utilisiez les données collectées de manière responsable.

[yasr_overall_rating]